Con la llegada de tecnologías emergentes como el aprendizaje profundo, la IA y el ML, las GPU en la nube tienen una gran demanda.

Si su organización se ocupa de visualizaciones 3D, aprendizaje automático (ML), inteligencia artificial (AI) o computación pesada de algún tipo, la forma en que realiza el cálculo de GPU es muy importante.

Tradicionalmente, los modelos de aprendizaje profundo en las organizaciones requerían una gran cantidad de tiempo para las tareas de capacitación y computación. Solía matar su tiempo, les costaba mucho y los dejaba con problemas de almacenamiento y espacio, lo que reducía la productividad.

Las GPU de la nueva era están diseñadas para resolver este problema. Ofrecen alta eficiencia para realizar cálculos pesados y un entrenamiento más rápido para sus modelos de IA en paralelo.

Según la investigación de Indigo, las GPU pueden ofrecer 250 veces más rápido rendimiento que las CPU al entrenar redes neuronales asociadas con el aprendizaje profundo.

Y con el avance de la computación en la nube, ahora tenemos GPU en la nube que están transformando el mundo de la ciencia de datos y otras tecnologías emergentes al ofrecer un rendimiento aún más rápido, fácil mantenimiento, costo reducido, escalado rápido y ahorro de tiempo.

Este artículo le presentará los conceptos de GPU en la nube, cómo se relaciona con AI, ML, aprendizaje profundo y algunas de las mejores plataformas de GPU en la nube que puede encontrar para implementar su GPU en la nube preferida.

¡Vamos a empezar!

Tabla de contenido

¿Qué es una GPU en la nube?

Para entender una GPU en la nube, primero hablemos de las GPU.

Una Unidad de procesamiento de gráficos (GPU) se refiere a un circuito electrónico especializado que se utiliza para alterar y manipular la memoria rápidamente para acelerar la creación de imágenes o gráficos.

Las GPU modernas ofrecen una mayor eficiencia en la manipulación del procesamiento de imágenes y gráficos de computadora debido a su estructura paralela que las Unidades Centrales de Procesamiento (CPU). Una GPU está incrustada en su placa base o se coloca en la tarjeta de video de una PC o en la matriz de CPU.

Las unidades de gráficos en la nube (GPU) son instancias informáticas con una sólida aceleración de hardware útil para ejecutar aplicaciones para manejar cargas de trabajo masivas de inteligencia artificial y aprendizaje profundo en la nube. No necesita que implemente una GPU física en su dispositivo.

Algunas GPU populares son NVIDIA, AMD, Radeon, GeForce y más.

Las GPU se utilizan en:

- Teléfonos móviles

- Consolas de juegos

- Estaciones de trabajo

- Sistemas embebidos

- Computadoras personales

Para qué se utilizan las GPU:

Estos son algunos casos de uso de las GPU:

- En AI y ML para reconocimiento de imágenes

- Cálculos para gráficos 3D por computadora y dibujos CAD

- Mapeo de texturas y polígonos de renderizado

- Cálculos geométricos como traslaciones y rotaciones de vértices en sistemas de coordenadas

- Admite sombreadores programables para manipular texturas y vértices

- Codificación, decodificación y transmisión de video acelerada por GPU

- Juegos ricos en gráficos y juegos en la nube

- Modelado matemático, análisis y aprendizaje profundo a gran escala que requieren capacidades de procesamiento paralelo de GPU de propósito general.

- Edición de video, diseño gráfico y creación de contenido.

¿Cuáles son los beneficios de las GPU en la nube? 👍

Los beneficios clave de usar GPU en la nube son:

Altamente escalable

Si desea expandir su organización, su carga de trabajo eventualmente aumentará. Necesitará una GPU que pueda escalar con su mayor carga de trabajo. Las GPU en la nube pueden ayudarlo a hacerlo al permitirle agregar más GPU fácilmente sin problemas para que pueda cumplir con sus mayores cargas de trabajo. Por el contrario, si desea reducir la escala, esto también es posible rápidamente.

Minimiza el costo

En lugar de comprar GPU físicas de alta potencia que cuestan increíblemente alto, puede alquilar GPU en la nube que está disponible a un costo más bajo por hora. Se le cobrará por la cantidad de horas que haya usado las GPU en la nube, a diferencia de las físicas que le habrían costado mucho aunque no las use mucho.

Borra los recursos locales

Las GPU en la nube no consumen sus recursos locales, a diferencia de las GPU físicas que ocupan una cantidad significativa de espacio en su computadora. Sin mencionar que si ejecuta un modelo ML a gran escala o procesa una tarea, ralentiza su computadora.

Para esto, puede considerar subcontratar el poder computacional a la nube sin estresar su computadora y usarla con facilidad. Simplemente use la computadora para controlar todo en lugar de darle toda la presión para manejar la carga de trabajo y las tareas computacionales.

Ahorra tiempo

Las GPU en la nube brindan a los diseñadores la flexibilidad de una iteración rápida con tiempos de renderizado más rápidos. Puede ahorrar mucho tiempo completando una tarea en minutos que antes tomaba horas o días. Por lo tanto, la productividad de su equipo aumentará significativamente para que pueda invertir tiempo en innovación en lugar de renderizado o cálculos.

¿Cómo ayudan las GPU en el aprendizaje profundo y la IA?

El aprendizaje profundo es la base de la inteligencia artificial. Es una técnica avanzada de ML que enfatiza el aprendizaje representacional con la ayuda de redes neuronales artificiales (ANN). El modelo de aprendizaje profundo se utiliza para procesar grandes conjuntos de datos o procesos altamente computacionales.

Entonces, ¿cómo entran en escena las GPU?

Las GPU están diseñadas para realizar cálculos paralelos o varios cálculos simultáneamente. Las GPU pueden aprovechar la capacidad del modelo de aprendizaje profundo para acelerar grandes tareas informáticas.

Como las GPU tienen muchos núcleos, ofrecen excelentes cálculos de procesamiento paralelo. Además, tienen un mayor ancho de banda de memoria para acomodar cantidades masivas de datos para sistemas de aprendizaje profundo. Por lo tanto, se usan ampliamente para entrenar modelos de IA, renderizar modelos CAD, jugar videojuegos ricos en gráficos y más.

Además, si desea experimentar con varios algoritmos simultáneamente, puede ejecutar numerosas GPU por separado. Facilita diferentes procesos en GPU separadas sin paralelismo. Para esto, puede usar múltiples GPU en diferentes máquinas físicas o en una sola máquina para distribuir modelos de datos pesados.

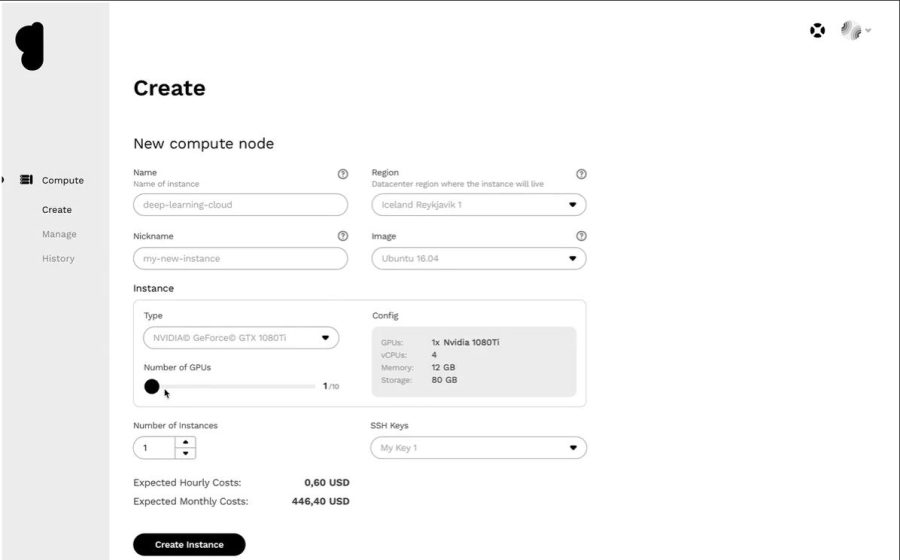

Cómo puede comenzar con la GPU en la nube

Comenzar con las GPU en la nube no es ciencia espacial. De hecho, todo es fácil y rápido si puede comprender los conceptos básicos. En primer lugar, debe elegir un proveedor de GPU en la nube, por ejemplo, Google Cloud Platform (GCP).

A continuación, regístrese en GCP. Aquí, puede aprovechar todos los beneficios estándar que vienen con él, como funciones en la nube, opciones de almacenamiento, administración de bases de datos, integración con aplicaciones y más. También puede usar su Google Colboratory que funciona como Jupyter Notebook para usar una GPU GRATIS. Finalmente, puede comenzar a renderizar GPU para su caso de uso.

Entonces, veamos varias opciones que tiene para que las GPU en la nube manejen la IA y las cargas de trabajo masivas.

Linodo

Linodo ofrece GPU bajo demanda para cargas de trabajo de procesamiento paralelo como procesamiento de video, computación científica, aprendizaje automático, IA y más. Proporciona máquinas virtuales optimizadas para GPU aceleradas por NVIDIA Quadro RTX 6000, Tensor, RT cores y aprovecha la potencia de CUDA para ejecutar cargas de trabajo de trazado de rayos, aprendizaje profundo y procesamiento complejo.

Convierta sus gastos de capital en gastos operativos tomando el acceso de la GPU Linode para aprovechar la potencia de la GPU y beneficiarse de la propuesta de valor real de la nube. Además, Linode le permite concentrarse en las competencias básicas en lugar de preocuparse por el hardware.

Las GPU Linode eliminan la barrera para aprovecharlas en casos de uso complejos como la transmisión de video, la IA y el aprendizaje automático. Además, obtendrá hasta 4 tarjetas por cada instancia, según la potencia que necesite para las cargas de trabajo proyectadas.

Quadro RTX 6000 tiene 4608 núcleos CUDA, 576 núcleos Tensor, 72 núcleos RT, 24 GB de memoria GPU GDDR6, 84T RTX-OPS, 10 Giga Rays/sec Rays Cast y un rendimiento FP32 de 16,3 TFLOP.

El precio del plan de GPU dedicado plus RTX6000 es de $1.5/hora.

NÚCLEO del espacio de papel

Potencie el flujo de trabajo de su organización con la infraestructura informática acelerada de próxima generación al NÚCLEO del espacio de papel. Ofrece una interfaz sencilla y fácil de usar para proporcionar herramientas sencillas de incorporación, colaboración y aplicaciones de escritorio para Mac, Linux y Windows. Úselo para ejecutar aplicaciones de alta demanda a través de una potencia informática ilimitada.

CORE proporciona una red ultrarrápida, aprovisionamiento instantáneo, compatibilidad con aplicaciones 3D y API completa para acceso mediante programación. Obtenga una vista completa de su infraestructura con una GUI sencilla e intuitiva en un solo lugar. Además, obtenga un control excelente con la interfaz de administración de CORE que presenta herramientas robustas y le permite filtrar, clasificar, conectar o crear máquinas, redes y usuarios.

La poderosa consola de administración de CORE realiza tareas rápidamente, como agregar integración de Active Directory o VPN. También puede administrar las configuraciones de red complejas fácilmente y completar las cosas más rápido con unos pocos clics.

Además, encontrará muchas integraciones que son opcionales pero útiles en su trabajo. Obtenga funciones de seguridad avanzadas, unidades compartidas y más con esta plataforma de GPU en la nube. Disfrute de las GPU de bajo costo al obtener descuentos educativos, alertas de facturación, facturación por segundo, etc.

Agregue simplicidad y velocidad al flujo de trabajo a un precio inicial de $0.07/hora.

GPU de Google Cloud

Obtenga GPU de alto rendimiento para computación científica, visualización 3D y aprendizaje automático con GPU de Google Cloud. Puede ayudar a acelerar HPC, seleccionar una amplia gama de GPU para igualar los puntos de precio y el rendimiento y minimizar su carga de trabajo con personalizaciones de máquinas y precios flexibles.

También ofrecen muchas GPU como NVIDIA K80, P4, V100, A100, T4 y P100. Además, las GPU de Google Cloud equilibran la memoria, el procesador, el disco de alto rendimiento y hasta 8 GPU en cada instancia para la carga de trabajo individual.

Además, obtiene acceso a redes, análisis de datos y almacenamiento líderes en la industria. Los dispositivos GPU solo están disponibles en zonas específicas de algunas regiones. El precio dependerá de la región, la GPU que elija y el tipo de máquina. Puede calcular su precio definiendo sus requisitos en la calculadora de precios de Google Cloud.

Alternativamente, puede optar por estas soluciones:

Servicio de GPU elástica

Servicio de GPU elástica (EGS) proporciona capacidades informáticas paralelas y potentes con tecnología GPU. Es ideal para muchos escenarios como procesamiento de video, visualización, computación científica y aprendizaje profundo. EGS utiliza varias GPU como NVIDIA Tesla M40, NVIDIA Tesla V100, NVIDIA Tesla P4, NVIDIA Tesla P100 y AMD FirePro S7150.

Obtendrá beneficios como capacitación y servicios de inferencia de aprendizaje profundo en línea, identificación de contenido, reconocimiento de imagen y voz, codificación de medios HD, videoconferencias, reparación de películas fuente y 4K/8K HD en vivo.

Además, obtenga opciones como reproducción de video, finanzas computacionales, predicción climática, simulación de colisiones, ingeniería genética, edición no lineal, aplicaciones de educación a distancia y diseño de ingeniería.

- La instancia GA1 proporciona hasta 4 GPU AMD FirePro S7150, 160 GB de memoria y 56 vCPU. Contiene 8192 núcleos y 32 GB de memoria GPU que funciona en paralelo y entrega 15 TFLOPS de precisión simple y un TFLOPS de precisión doble.

- La instancia GN4 proporciona hasta 2 GPU NVIDIA Tesla M40, 96 GB de memoria y 56 vCPU. Contiene 6000 núcleos y 24 GB de memoria GPU que ofrece 14 TFLOPS de precisión simple. Del mismo modo, encontrará muchas instancias como GN5, GN5i y GN6.

- EGS admite 25 Gbit/s y hasta 2 000 000 PPS de ancho de banda de red internamente para proporcionar el máximo rendimiento de red que necesitan los nodos computacionales. Tiene un caché local de alta velocidad que se adjunta con discos SSD o ultranube.

- Las unidades NVMe de alto rendimiento manejan 230 000 IOPS con una latencia de E/S de 200 𝝻s y proporcionan 1900 Mbit/s de ancho de banda de lectura y 1100 Mbit/s de ancho de banda de escritura.

Puede elegir entre diferentes opciones de compra según sus necesidades para obtener los recursos y pagar solo por eso.

Serie N azul

Serie N azul de Azure Virtual Machines (VM) tienen capacidades de GPU. Las GPU son ideales para gráficos y cargas de trabajo intensivas en computación, ya que ayudan a los usuarios a impulsar la innovación a través de varios escenarios como el aprendizaje profundo, el análisis predictivo y la visualización remota.

Las diferentes series N tienen ofertas separadas para cargas de trabajo específicas.

- La serie NC se centra en el aprendizaje automático de alto rendimiento y las cargas de trabajo informáticas. La última versión es NCsv3, que cuenta con la GPU Tesla V100 de NVIDIA de NVIDIA.

- La serie ND se enfoca en escenarios de inferencia y entrenamiento básicamente para el aprendizaje profundo. Utiliza GPU NVIDIA Tesla P40. La última versión es NDv2 que cuenta con GPU NVIDIA Tesla V100.

- La serie NV se centra en la visualización remota y otras cargas de trabajo de aplicaciones intensivas respaldadas por NVIDIA Tesla M60 GPU.

- Las máquinas virtuales NC, NCsv3, ND y NCsv2 ofrecen interconexión InfiniBand que permite escalar el rendimiento. Aquí, obtendrá los beneficios como el aprendizaje profundo, la representación gráfica, la edición de video, los juegos, etc.

Nube de IBM

Nube de IBM le ofrece flexibilidad, potencia y muchas opciones de GPU. Dado que la GPU es la capacidad intelectual adicional de la que carece una CPU, IBM Cloud lo ayuda a obtener acceso directo a la selección más accesible del servidor para una integración perfecta con la arquitectura, las aplicaciones y las API de IBM Cloud junto con una red distribuida de centros de datos a nivel mundial.

- Obtendrá opciones de GPU de servidor bare metal como Intel Xeon 4210, tarjeta gráfica NVIDIA T4, 20 núcleos, 32 GB de RAM, 2,20 GHz y 20 TB de ancho de banda. Del mismo modo, también obtiene opciones de Intel Xeon 5218 e Intel Xeon 6248.

- Para servidores virtuales, obtiene AC1.8×60 que tiene ocho vCPU, 60 GB de RAM, 1 x GPU P100. Aquí, también obtendrá las opciones de AC2.8×60 y AC2.8×60.

Obtenga la GPU de servidor bare metal a un precio inicial de $819/mes y la GPU de servidor virtual a un precio inicial de $1.95/hora.

AWS y NVIDIA

AWS y NVIDIA han colaborado para ofrecer continuamente soluciones rentables, flexibles y potentes basadas en GPU. Incluye instancias de Amazon EC2 con GPU NVIDIA y servicios como AWS IoT Greengrass que se implementa con módulos NVIDIA Jetson Nano.

Los usuarios utilizan AWS y NVIDIA para estaciones de trabajo virtuales, aprendizaje automático (ML), servicios de IoT y computación de alto rendimiento. Las instancias de Amazon EC2 potenciadas por las GPU de NVIDIA son responsables de ofrecer un rendimiento escalable. Además, use AWS IoT Greengrass para extender los servicios en la nube de AWS a los dispositivos perimetrales basados en NVIDIA.

Las GPU NVIDIA A100 Tensor Core potencian las instancias Amazon EC2 P4d para ofrecer redes de baja latencia líderes en la industria y alto rendimiento. De igual forma, encontrarás muchas otras instancias para escenarios específicos como Amazon EC2 P3, Amazon EC2 G4, etc.

Solicite la prueba GRATUITA y experimente el poder de la GPU hasta el borde desde la nube.

OVHcloud

OVHcloud proporciona servidores en la nube que están diseñados para procesar cargas de trabajo paralelas masivas. Las GPU tienen muchas instancias integradas con los procesadores gráficos NVIDIA Tesla V100 para satisfacer las necesidades de aprendizaje profundo y aprendizaje automático.

Ayudan a acelerar la computación en el campo de la computación gráfica así como la inteligencia artificial. OVH se asocia con NVIDIA para ofrecer la mejor plataforma acelerada por GPU para computación de alto rendimiento, IA y aprendizaje profundo.

Utilice la forma más sencilla de implementar y mantener contenedores acelerados por GPU a través de un catálogo completo. Entrega una de las cuatro tarjetas a las instancias directamente a través de PCI Passthrough sin ninguna capa de virtualización para dedicar todos los poderes a su uso.

Los servicios e infraestructuras de OVHcloud cuentan con las certificaciones ISO/IEC 27017, 27001, 27701 y 27018. Las certificaciones indican que OVHcloud cuenta con un sistema de gestión de la seguridad de la información (SGSI) para gestionar vulnerabilidades, implementar la continuidad del negocio, gestionar los riesgos e implementar un sistema de gestión de la privacidad de la información (PIMS).

Además, NVIDIA Tesla V100 tiene muchas características valiosas, como PCIe 32 GB/s, 16 GB HBM2 de capacidad, 900 GB/s de ancho de banda, 7 teraFLOP de precisión doble, 14 teraFLOP de precisión simple y 112 teraFLOP de aprendizaje profundo.

GPU lambda

Entrene modelos de aprendizaje profundo, ML e IA con Nube de GPU Lambda y escale desde una máquina hasta el número total de máquinas virtuales en cuestión de unos pocos clics. Obtenga marcos principales preinstalados y la última versión de lambda Stack que incluye controladores CUDA y marcos de aprendizaje profundo.

Obtenga acceso al entorno de desarrollo dedicado de Jupyter Notebook para cada máquina rápidamente desde el tablero. Utilice SSH directamente con una de las claves SSH o conéctese a través de la Terminal web en el panel de control de la nube para acceder directamente.

Cada instancia admite un máximo de 10 Gbps de ancho de banda entre nodos que permite el entrenamiento disperso con marcos como Horovod. También puede ahorrar tiempo en la optimización del modelo escalando a la cantidad de GPU en instancias únicas o múltiples.

Con Lambda GPU Cloud, puede incluso ahorrar un 50 % en computación, reducir el costo total de propiedad de la nube y nunca tendrá compromisos de varios años. Use una sola GPU RTX 6000 con seis VCPU, 46 GiB de RAM, 658 GiB de almacenamiento temporal a solo $1.25/hora. Elija entre muchas instancias de acuerdo con sus requisitos para obtener un precio bajo demanda para su uso.

Nube de Génesis

Obtenga una plataforma de GPU en la nube eficiente a un precio muy asequible de Nube de Génesis. Tienen acceso a muchos centros de datos eficientes en todo el mundo con los que colaboran para ofrecer una amplia gama de aplicaciones.

Todos los servicios son seguros, escalables, robustos y automatizados. Genesis Cloud proporciona poder de cómputo de GPU ilimitado para efectos visuales, aprendizaje automático, transcodificación o almacenamiento, análisis de Big Data y mucho más.

Genesis Cloud ofrece muchas funciones completas GRATIS, como instantáneas para guardar su trabajo, grupos de seguridad para el tráfico de la red, volúmenes de almacenamiento para grandes conjuntos de datos, FastAI, PyTorch, imágenes preconfiguradas y una API pública para TensorFlow.

Tiene GPU NVIDIA y AMD de diferentes tipos. Además, entrene la red neuronal o genere películas animadas aprovechando el poder de la computación GPU. Sus centros de datos funcionan con energía 100 % renovable de fuentes geotérmicas para reducir las emisiones de carbono.

Su precio es un 85 % más bajo que el de otros proveedores, ya que pagará por incrementos de nivel de minutos. También puede ahorrar más con descuentos a largo plazo y preferenciales.

Conclusión 👩🏫

Las GPU en la nube están diseñadas para ofrecer un rendimiento, velocidad, escalabilidad, espacio y comodidad increíbles. Por lo tanto, considere elegir su plataforma de GPU en la nube preferida con capacidades listas para usar para acelerar sus modelos de aprendizaje profundo y manejar cargas de trabajo de IA fácilmente.