Existen terabytes y petabytes de datos en esta era de Internet, con un crecimiento exponencial de los mismos. Pero, ¿cómo consumimos estos datos y los traducimos en información útil para mejorar la disponibilidad del servicio?

Los datos válidos, novedosos y comprensibles son todo lo que las empresas necesitan para sus modelos de descubrimiento de conocimiento.

Por esta razón, las empresas están aplicando análisis de muchas maneras diferentes para descubrir datos de calidad.

Pero, ¿dónde comienza todo? La respuesta es la disputa de datos.

¡Empecemos!

Tabla de contenido

¿Qué es la disputa de datos?

La disputa de datos es el acto de limpiar, estructurar y transformar datos sin procesar en formatos que simplifican los procesos de análisis de datos. La disputa de datos a menudo implica trabajar con conjuntos de datos complejos y desordenados que no están listos para los procesos de canalización de datos. La disputa de datos mueve los datos sin procesar a un estado refinado o los datos refinados a un estado optimizado y un nivel listo para la producción.

Algunas de las tareas conocidas en la disputa de datos incluyen:

- Fusión de múltiples conjuntos de datos en un gran conjunto de datos para su análisis.

- Examinar faltantes/vacíos en los datos.

- Eliminación de valores atípicos o anomalías en conjuntos de datos.

- Estandarización de insumos.

Los grandes almacenes de datos involucrados en los procesos de disputa de datos generalmente están más allá del ajuste manual, lo que requiere métodos de preparación de datos automatizados para producir datos más precisos y de calidad.

Objetivos de la disputa de datos

Además de preparar los datos para el análisis como el objetivo principal, otros objetivos incluyen:

- Crear datos válidos y novedosos a partir de datos desordenados para impulsar la toma de decisiones en las empresas.

- Estandarización de datos sin procesar en formatos que los sistemas Big Data pueden ingerir.

- Reducir el tiempo que dedican los analistas de datos al crear modelos de datos mediante la presentación de datos ordenados.

- Creando consistencia, integridad, facilidad de uso y seguridad para cualquier conjunto de datos consumido o almacenado en un almacén de datos.

Enfoques comunes para la disputa de datos

Descubriendo

Antes de que los ingenieros de datos comiencen las tareas de preparación de datos, deben comprender cómo se almacenan, el tamaño, qué registros se mantienen, los formatos de codificación y otros atributos que describen cualquier conjunto de datos.

Estructuración

Este proceso involucra la organización de datos para tomar formatos fácilmente utilizables. Los conjuntos de datos sin procesar pueden necesitar una estructuración en la forma en que aparecen las columnas, la cantidad de filas y el ajuste de otros atributos de datos para simplificar el análisis.

Limpieza

Los conjuntos de datos estructurados deben deshacerse de los errores inherentes y cualquier cosa que pueda sesgar los datos que contienen. Por lo tanto, la limpieza implica la eliminación de múltiples entradas de celdas con datos similares, la eliminación de celdas vacías y datos atípicos, la estandarización de entradas, el cambio de nombre de atributos confusos y más.

enriquecedor

Una vez que los datos han pasado las etapas de estructuración y limpieza, es necesario evaluar la utilidad de los datos y aumentarla con valores de otros conjuntos de datos que faltan para brindar la calidad de datos deseada.

Validando

El proceso de validación implica aspectos de programación iterativos que arrojan luz sobre la calidad, consistencia, usabilidad y seguridad de los datos. La fase de validación garantiza que se logren todas las tareas de transformación y marca los conjuntos de datos como listos para las fases de análisis y modelado.

Presentación

Después de pasar todas las etapas, los conjuntos de datos discutidos se presentan/comparten dentro de una organización para su análisis. En esta etapa también se comparte la documentación de los pasos de preparación y los metadatos generados a lo largo del proceso de disputa.

Talend

Talend es una plataforma de gestión de datos unificada envuelta en 3 estructuras de datos para proporcionar datos fiables y saludables. Talend presenta Integración de datos, Aplicación e integración e Integridad y gobierno de datos. La gestión de datos en Talend se realiza a través de una herramienta de apuntar y hacer clic basada en un navegador que permite la preparación de datos por lotes, en masa y en vivo: creación de perfiles, limpieza y documentación de datos.

La estructura de datos de Talend gestiona todas las etapas del ciclo de vida de los datos, equilibrando cuidadosamente la disponibilidad, la facilidad de uso, la seguridad y la integridad de todos los datos empresariales.

¿Alguna vez se preocupó por sus diversas fuentes de datos? El enfoque unificado de Talend proporciona una rápida integración de datos de todas sus fuentes de datos (bases de datos, almacenamiento en la nube y puntos finales de API), lo que permite la transformación y el mapeo de todos los datos con controles de calidad continuos.

La integración de datos en Talend se habilita a través de herramientas de autoservicio como conectores que permiten a los desarrolladores ingerir datos de cualquier fuente automáticamente y categorizar adecuadamente los datos.

Características de Talend

Integración universal de datos

Talend permite a las empresas gestionar cualquier tipo de datos de diversas fuentes de datos: entornos en la nube o locales.

Flexible

Talend va más allá del proveedor o la plataforma cuando crea canalizaciones de datos a partir de sus datos integrados. Una vez que crea canalizaciones de datos a partir de sus datos ingeridos, Talend le permite ejecutar las canalizaciones en cualquier lugar.

Calidad de los datos

Con capacidades de aprendizaje automático, como deduplicación, validación y estandarización de datos, Talend limpia automáticamente los datos ingeridos.

Soporte para integraciones de aplicaciones y API

Una vez que sus datos tienen significado a través de las herramientas de autoservicio de Talend, puede compartir sus datos a través de API fáciles de usar. Los terminales de API de Talend pueden exponer sus activos de datos a plataformas SaaS, JSON, AVRO y B2B a través de herramientas avanzadas de mapeo y transformación de datos.

R

R es un lenguaje de programación bien desarrollado y efectivo para abordar el análisis exploratorio de datos para aplicaciones científicas y comerciales.

Construido como software gratuito para computación estadística y gráficos, R es tanto un lenguaje como un entorno para la visualización, el modelado y la disputa de datos. El entorno R proporciona un conjunto de paquetes de software, mientras que el lenguaje R integra una serie de técnicas estadísticas, de agrupación, de clasificación, de análisis y gráficas que ayudan a manipular los datos.

Características de R

Conjunto rico de paquetes

Los ingenieros de datos tienen más de 10 000 paquetes y extensiones estandarizados para seleccionar de Comprehensive R Archive Network (CRAN). Esto simplifica las disputas y el análisis de datos.

Extremadamente poderoso

Con los paquetes informáticos distribuidos disponibles, R puede realizar manipulaciones complejas y sencillas (matemáticas y estadísticas) en objetos y conjuntos de datos en cuestión de segundos.

Soporte multiplataforma

R es independiente de la plataforma, capaz de ejecutarse en muchos sistemas operativos. También es compatible con otros lenguajes de programación que ayudan en la manipulación de tareas computacionalmente pesadas.

Aprender R es fácil.

Trifacta

Trifacta es un entorno de nube interactivo para generar perfiles de datos que se ejecutan en modelos analíticos y de aprendizaje automático. Esta herramienta de ingeniería de datos tiene como objetivo crear datos comprensibles independientemente de cuán desordenados o complejos sean los conjuntos de datos. Los usuarios pueden eliminar entradas dobles y llenar celdas en blanco en conjuntos de datos a través de transformaciones de deduplicación y transformación lineal.

Esta herramienta de disputa de datos tiene buen ojo para los valores atípicos y los datos no válidos en cualquier conjunto de datos. Con solo hacer clic y arrastrar, los datos disponibles se clasifican y transforman de manera inteligente utilizando sugerencias impulsadas por el aprendizaje automático para acelerar la preparación de datos.

La disputa de datos en Trifacta se realiza a través de perfiles visuales convincentes que pueden acomodar al personal técnico y no técnico. Con las transformaciones visualizadas e inteligentes, Trifacta se enorgullece de su diseño pensando en los usuarios.

Ya sea que incorporen datos de data marts, almacenes de datos o lagos de datos, los usuarios están protegidos de las complejidades de la preparación de datos.

Características de Trifacta

Integraciones perfectas en la nube

Admite cargas de trabajo de preparación en cualquier nube o entorno híbrido para permitir que los desarrolladores ingieran conjuntos de datos para disputar sin importar dónde vivan.

Múltiples métodos de estandarización de datos

Trifacta Wrangler tiene varios mecanismos para identificar patrones en los datos y estandarizar los resultados. Los ingenieros de datos pueden elegir la estandarización por patrón, por función o mezclar y combinar.

Flujo de trabajo sencillo

Trifacta organiza los trabajos de preparación de datos en forma de flujos. Un flujo contiene uno o más conjuntos de datos más sus recetas asociadas (pasos definidos que transforman los datos).

Por lo tanto, un flujo reduce el tiempo que los desarrolladores dedican a la importación, disputa, creación de perfiles y exportación de datos.

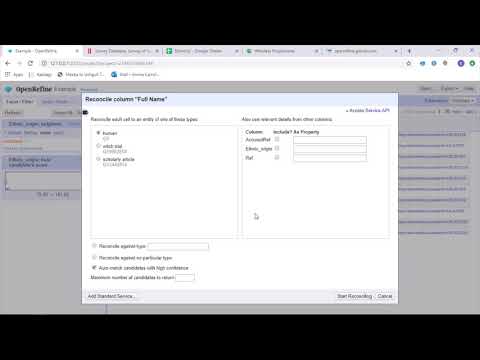

AbrirRefinar

AbrirRefinar es una herramienta madura de código abierto para trabajar con datos desordenados. Como herramienta de limpieza de datos, OpenRefine explora conjuntos de datos en cuestión de segundos mientras aplica transformaciones de celdas complejas para presentar los formatos de datos deseados.

OpenRefine aborda la disputa de datos a través de filtros y particiones en conjuntos de datos mediante expresiones regulares. Usando el lenguaje de expresión de refinación general incorporado, los ingenieros de datos pueden aprender y ver datos usando facetas, filtros y técnicas de clasificación antes de realizar operaciones de datos avanzadas para extracciones de entidades.

OpenRefine permite a los usuarios trabajar en datos como proyectos donde los conjuntos de datos de múltiples archivos de computadora, URL web y bases de datos pueden incorporarse a dichos proyectos con la capacidad de ejecutarse localmente en las máquinas de los usuarios.

A través de expresiones, los desarrolladores pueden extender la limpieza y transformación de datos a tareas como dividir/unir celdas de varios valores, personalizar facetas y obtener datos en columnas usando URL externas.

Características de OpenRefine

Herramienta multiplataforma

OpenRefine está diseñado para funcionar con los sistemas operativos Windows, Mac y Linux a través de configuraciones de instalación descargables.

Amplio conjunto de API

Presenta la API de OpenRefine, la API de extensión de datos, la API de reconciliación y otras API que admiten la interacción de los usuarios con los datos.

Datameer

Datameer es una herramienta de transformación de datos SaaS creada para simplificar la integración y la recopilación de datos a través de procesos de ingeniería de software. Datameer permite la extracción, transformación y carga de conjuntos de datos en almacenes de datos en la nube como Snowflake.

Esta herramienta de gestión de datos funciona bien con formatos de conjuntos de datos estándar como CSV y JSON, lo que permite a los ingenieros importar datos en diversos formatos para su agregación.

Datameer presenta documentación de datos similar a un catálogo, creación de perfiles de datos profundos y descubrimiento para satisfacer todas las necesidades de transformación de datos. La herramienta mantiene un perfil de datos visual profundo que permite a los usuarios rastrear campos y valores no válidos, faltantes o atípicos y la forma general de los datos.

Al ejecutarse en un almacén de datos escalable, Datameer transforma los datos para realizar análisis significativos a través de pilas de datos eficientes y funciones similares a las de Excel.

Datameer presenta una interfaz de usuario híbrida, con código y sin código para adaptarse a amplios equipos de análisis de datos que pueden construir fácilmente canalizaciones ETL complejas.

Características de Datameer

Múltiples entornos de usuario

Cuenta con entornos de transformación de datos de varias personas: código bajo, código e híbrido, para admitir personas con conocimientos tecnológicos y no técnicos.

Espacios de trabajo compartidos

Datameer permite que los equipos reutilicen y colaboren en modelos para acelerar los proyectos.

Documentación rica en datos

Datameer es compatible con la documentación de datos generados por el sistema y por el usuario a través de metadatos y descripciones, etiquetas y comentarios de estilo wiki.

Palabras finales 👩🏫

El análisis de datos es un proceso complejo que requiere que los datos se organicen adecuadamente para extraer inferencias significativas y hacer predicciones. Las herramientas de Data Wrangling lo ayudan a formatear grandes cantidades de datos sin procesar para ayudarlo a realizar análisis avanzados. ¡Elija la mejor herramienta que se adapte a sus necesidades y conviértase en un profesional de Analytics!

Te podría gustar:

Las mejores herramientas CSV para convertir, formatear y validar.