Muchas organizaciones realizan web scraping para extraer información de Internet y organizarla y analizarla para impulsar sus procesos comerciales.

Sin embargo, si continúa realizando web scraping de forma manual, visitando cientos de sitios web y extrayendo datos continuamente, puede convertirse en una tarea dolorosa (y riesgosa).

Es posible que enfrente restricciones geográficas o que se le excluya de esos sitios, ya que todos quieren proteger sus datos.

Por lo tanto, usar una herramienta como un recopilador de datos puede ser una buena manera de hacerlo.

Un buen recolector de datos lo ayudará a recopilar datos con velocidad, seguridad y confiabilidad. Por lo tanto, puede usar datos de calidad para hacer predicciones, agilizar procesos y dar forma a sus operaciones.

En este artículo, discutiré qué significa la recopilación de datos, sus tipos y técnicas, y luego le presentaré algunas de las mejores herramientas de recopilación de datos.

¡Empecemos!

Tabla de contenido

¿Qué es la recopilación de datos?

La recopilación de datos es un proceso de recopilación y análisis de información específica para resolver ciertas preguntas y evaluar los resultados. Su objetivo es encontrar todo sobre un tema determinado. Después de recopilar datos, se somete a un proceso de prueba de hipótesis para explicar algo o evento en particular.

La recopilación de datos se puede realizar por varias razones, como predecir tendencias y probabilidades futuras.

Y la herramienta que ayuda a realizar la recopilación de datos es un recopilador de datos o un software de recopilación de datos. Viene con increíbles características y beneficios para ayudar en el proceso completo de recopilación de datos.

Tipos de recopilación de datos

La recopilación de datos se incluye en estas dos categorías principales: recopilación de datos primarios y secundarios.

Recopilación de datos primarios

La recopilación de datos primarios implica el proceso de recopilación de datos sin procesar en la fuente o datos originales para un propósito específico, ya sea web scraping, investigación o cualquier otro objetivo. Se divide además en dos tipos:

- Recopilación de datos cuantitativos: existen muchos métodos empleados en la recopilación de datos cuantitativos, como la recopilación de datos por teléfono, correo electrónico, en línea o cara a cara. Estos métodos requieren un cálculo matemático para comprenderlos y se presentan en números. Ejemplos de estos métodos podrían ser cuestionarios con preguntas cerradas, regresión, mediana, media y moda.

- Investigación cualitativa: este es un método de recopilación de datos que no implica cálculos matemáticos ni números. Se basa en elementos que no son cuantificables, como las emociones o sentimientos del investigador. Dichas técnicas podrían incluir cuestionarios abiertos, entrevistas en profundidad, encuestas web y datos recopilados de comunidades en línea, foros en línea, grupos, etc.

Recopilación de datos secundarios

La recopilación de datos secundarios implica recopilar datos de segunda mano recopilados por alguien que no es el usuario original. Esto significa que, en este proceso, recopila datos existentes de libros publicados, portales en línea, revistas, etc. Este proceso es más fácil y menos costoso.

En este tipo de recopilación de datos, puede obtener toda la información analizada por alguien antes. La recopilación de datos secundarios implica dos tipos de datos:

- Datos publicados: pueden ser publicaciones gubernamentales, un podcast, sitios web, registros públicos, documentos estadísticos e históricos, revistas comerciales, archivos técnicos, documentos comerciales, etc.

- Datos Inéditos: Puede ser de cartas, diarios y biografías inéditas.

Por lo tanto, elegir uno entre la recopilación de datos primaria y secundaria depende de su área específica de investigación, tipo de nicho, oportunidad, objetivo del proyecto, etc. Elige el que más te convenga para tomar decisiones inteligentes.

Beneficios de la herramienta de recopilación de datos

Como se explicó anteriormente, una herramienta de recopilación de datos o recopilador de datos es un software utilizado para la recopilación de datos a través de cuestionarios en papel, encuestas, estudios de casos, investigación, observación, etc.

Dado que un estudio, análisis, investigación o web scraping se realiza con varios propósitos, debe asegurarse de recopilar datos genuinos y de calidad para generar soluciones creíbles para un problema determinado. Aquí es donde es necesario utilizar una buena herramienta de recopilación de datos. Ofrece muchas características y beneficios para que su proceso de recopilación de datos sea sencillo y satisfactorio.

Estos son algunos de los beneficios de usar una herramienta de recopilación de datos.

Precisión

Las herramientas modernas de recopilación de datos cuentan con una amplia biblioteca de información confiable. Esta base de datos también se actualiza con frecuencia para ofrecerle información nueva y actualizada que no solo es relevante para su organización sino también precisa.

Más rápido

Los recopiladores de datos ayudan a acelerar el proceso de web scraping o investigación. La razón es que está conectado a una base de datos con una gran cantidad de información útil a la que puede acceder desde cualquier lugar y en cualquier momento con unos pocos clics. Por lo tanto, puede realizar su investigación sobre la marcha o en su oficina u hogar. Acelera el proceso completo de recopilación de datos y le ahorra mucho tiempo.

menos errores

Si bien puede recopilar datos manualmente para su caso de uso, puede implicar errores humanos. Sin embargo, el uso de una herramienta de recopilación de datos dedicada le proporcionará información precisa y consistente para impulsar sus procesos y objetivos comerciales. También lo ayudará a mantener la integridad de su investigación, estudio o web scraping.

Mejores resultados

Dado que obtiene datos completos, confiables, sin errores y relevantes utilizando una herramienta de recopilación de datos para su propósito previsto, obtendrá mejores resultados en lugar de cometer errores que pueden generar más problemas. El uso de datos precisos, relevantes, completos y confiables lo ayudará a tomar mejores decisiones comerciales y a corregir las predicciones.

Recopilación de datos frente a soluciones tradicionales de web scraping

Los web scrapers tradicionales pueden ser versátiles, pero pueden consumir mucho tiempo y requerir más esfuerzo. Es evidente, especialmente si se trata de grandes volúmenes de datos. Dado que Internet tiene billones de datos, que consisten en tantas encuestas, foros, sitios en línea, informes, etc., extraer información útil y relevante es un desafío.

Sin embargo, al utilizar una herramienta avanzada de recopilación de datos como Bright Data Collector, puede recopilar datos de forma rápida, fácil y de una manera un poco más emocionante.

Con tantos recopiladores de datos disponibles en Internet, a muchos les resulta difícil elegir uno. Entonces, aquí le mostramos cómo elegir la herramienta de recopilación de datos adecuada para sus necesidades.

¿Cómo elegir la herramienta de recopilación de datos adecuada?

Al elegir una herramienta de recopilación de datos, busque estos aspectos:

- Funciones útiles: elija un recopilador de datos que tenga funciones útiles para sus casos de uso. Evalúe sus requisitos y luego elija la herramienta que pueda ofrecerle las funciones que realmente va a utilizar. También debe integrarse con otras herramientas para facilitar el trabajo utilizando una sola herramienta.

- Fácil de usar: si desea aprovechar al máximo un recopilador de datos, busque uno que sea fácil de usar. Debe tener una interfaz simple pero poderosa, fácil navegación y accesibilidad sin esfuerzo.

- Asequibilidad: invierta en una herramienta que se ajuste a su presupuesto pero que tenga un buen conjunto de características útiles. Se trata de encontrar el equilibrio. Además, busque una versión de prueba gratuita para comprobar cómo funciona para usted.

Entonces, si está buscando una buena herramienta de recopilación de datos, Bright Data Collector es una buena opción. Conozcamos esta herramienta para decidir si funcionará para usted.

¿Cómo puede ayudar Bright Data?

Bright Data Collector es una de las mejores plataformas para realizar la recopilación de datos y el web scraping. Extrae datos de Internet a escala sin requisitos de infraestructura. Puede extraer instantáneamente datos disponibles públicamente desde cualquier sitio para que pueda alimentar sus requisitos de investigación o raspado web.

Puede optar por extraer datos web en lotes o en tiempo real. Simplemente evalúe sus requisitos y use Bright Data Collector para satisfacer sus necesidades.

Colector de datos Bright: características clave

Algunas características clave de Bright Data Collector son:

Plataforma sin código

Simplifique sus esfuerzos de web scraping utilizando la plataforma sin código de Bright Data Collector. Esto significa que no tiene que lidiar con ninguna codificación para usar esta solución y realizar el raspado.

Anteriormente, este proceso era complicado y requería que los programadores configuraran la herramienta correctamente. También requería especialistas en adquisición de datos en raspado de datos web y administración de proxy.

Por lo tanto, con una plataforma sin código, Bright Data Collector se vuelve fácil de usar para todos, ya sea que sea un programador o un especialista experto en extracción de datos. Le ahorrará muchas horas, recursos y tiempo que puede dedicar a otras tareas importantes.

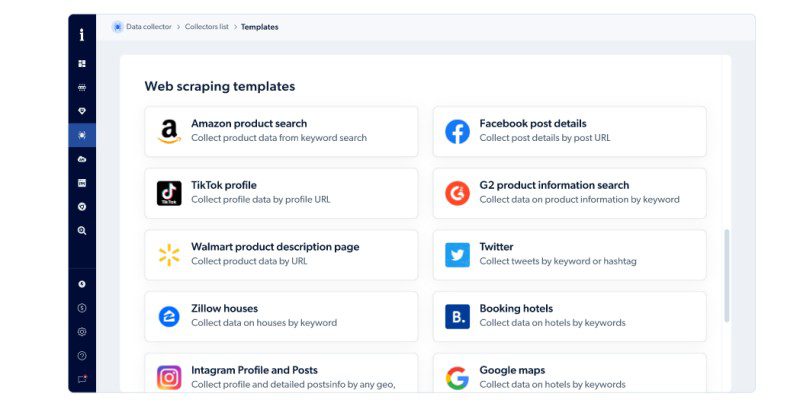

Plantillas y funciones de codificación prefabricadas

Obtendrá plantillas y funciones de codificación prefabricadas en la solución alojada de Bright Data. Esto facilitará la creación de una herramienta de web scraping fácilmente a escala. De esta manera, puede recopilar datos web disponibles públicamente más rápido en tiempo real utilizando su IDE de JavaScript. También puede conectar su API a un flujo de trabajo y disfrutar de un proceso de recopilación de datos optimizado y fluido.

Bright Data Collector ofrece plantillas de raspado web para búsquedas de productos de Amazon, casas de Zillow, perfiles y publicaciones de Instagram, Google Maps, Twitter, detalles de publicaciones de Facebook, páginas de descripción de productos de Walmart y más.

Estructuración perfecta

Bright Data Collector utiliza algoritmos de inteligencia artificial para combinar, limpiar, procesar, estructurar y sintetizar sin problemas los datos no estructurados de un sitio antes de la entrega. Por lo tanto, los conjuntos de datos obtenidos podrían estar listos para el análisis más rápido.

Flexibilidad automatizada

Las estructuras de página en los sitios web siguen cambiando. Por lo tanto, extraer datos de dichos sitios podría ser complicado y confuso. Pero no te preocupes; Bright Data Collector ofrece una excelente solución a este problema. Puede adaptarse rápidamente a los cambios estructurales en los sitios web y extraer datos útiles para impulsar su proceso de análisis.

Escalamiento de nivel empresarial

La recopilación de datos a escala requiere una sólida infraestructura de hardware y software, así como tiempo y recursos. Este es un trato costoso y podría ser un posible obstáculo para las organizaciones con presupuestos limitados.

Pero Bright Data Collector puede ayudarlo aquí. Recopilará datos precisos y útiles de manera fácil y confiable a escala. No necesitará invertir en una costosa infraestructura de hardware o software, por lo que ahorrará dinero.

Cumplimiento

Es importante cumplir con las normas y reglamentos aplicables en su región o país. No solo lo salvará de sanciones, sino que también ayudará a preservar la confianza de sus clientes y empleados.

Bright Data Collector cumple totalmente con las normas de protección de datos, incluidos el RGPD, la UE y la CCPA. Por lo tanto, puede realizar web scraping sin preocupaciones. Este intento de protección de datos también lo ayudará a pasar auditorías rápidamente.

Versatilidad

Bright Data Collector ha establecido las mejores prácticas y pautas integrales sobre cómo usar esta plataforma al tiempo que garantiza la protección de datos. Es por eso que no solo confían en él corporaciones de todas las formas y tamaños, sino también gobiernos y universidades.

Infraestructura robusta de red de proxy

Bright Data tiene una infraestructura de red proxy patentada y líder en la industria. Y Data Collector está construido sobre esta infraestructura. Por lo tanto, no tendrá ninguna dificultad para acceder a cualquier sitio web público. Superará todos los obstáculos, como restricciones geográficas, accesibilidad, etc. Por lo tanto, puede extraer datos de cualquier lugar que desee que estén disponibles públicamente.

Trabaja como un socio comercial

Puede utilizar esta plataforma de autoservicio o aprovechar sus recursos de desarrollo. Sus desarrolladores, gerentes de productos y gerentes de cuentas pueden ayudarlo en cada paso del camino para resolver los problemas de su negocio y satisfacer sus necesidades para ayudarlo a registrar un mayor crecimiento.

¿Cómo funciona el recopilador de datos de Bright?

El uso de Bright Data Collector no requiere que sea un codificador o un especialista en web scraping. En cambio, puede instalar y usar esta plataforma fácilmente sin requerir la ayuda necesaria.

Puedes trabajar con él en tres sencillos pasos:

Elija una plantilla

Elija una plantilla de oda prefabricada de las opciones dadas según sus requisitos. También tiene la opción de crear uno desde cero en lugar de usar plantillas prefabricadas.

Por ejemplo, si está buscando listados de productos en Amazon, es posible que desee utilizar la plantilla para la búsqueda de productos de Amazon.

personalizar

El siguiente paso es personalizar o desarrollar su raspador web previsto utilizando las funciones de raspado preconstruidas de Bright Data Collector.

Si no sabes codificar, está bien. Esta solución sin código es su software de referencia para crear un raspador web desde cero utilizando la opción disponible. Sin embargo, si sabes codificar, puedes hacer mucho más que eso. Puede editar el código para que el raspador se adapte mejor a sus necesidades.

En tiempo real o por lotes

Después de crear el raspador web para su caso de uso específico, elija cuándo desea recibir los datos: en lotes o en tiempo real. La frecuencia de los datos depende totalmente de tus necesidades. Por lo tanto, primero evalúe sus necesidades y luego elija una opción para continuar con el siguiente paso.

Formato y Entrega

En este paso, debe elegir el formato de archivo en el que desea recuperar los datos. Podría ser CSV, JSON, XLSX o NDJSON.

A continuación, seleccione la opción donde desea enviar los datos que ha recopilado. Obtendrá estas opciones: correo electrónico, webhook, API, Google Cloud, Amazon S3, MS Azure y SFTP.

Atención al cliente

Si está atascado en algún lugar, puede buscar ayuda del soporte técnico 24/7 de Bright Data. Son útiles y están bien informados para resolver sus problemas las 24 horas del día.

Precios: Bright Data Collector

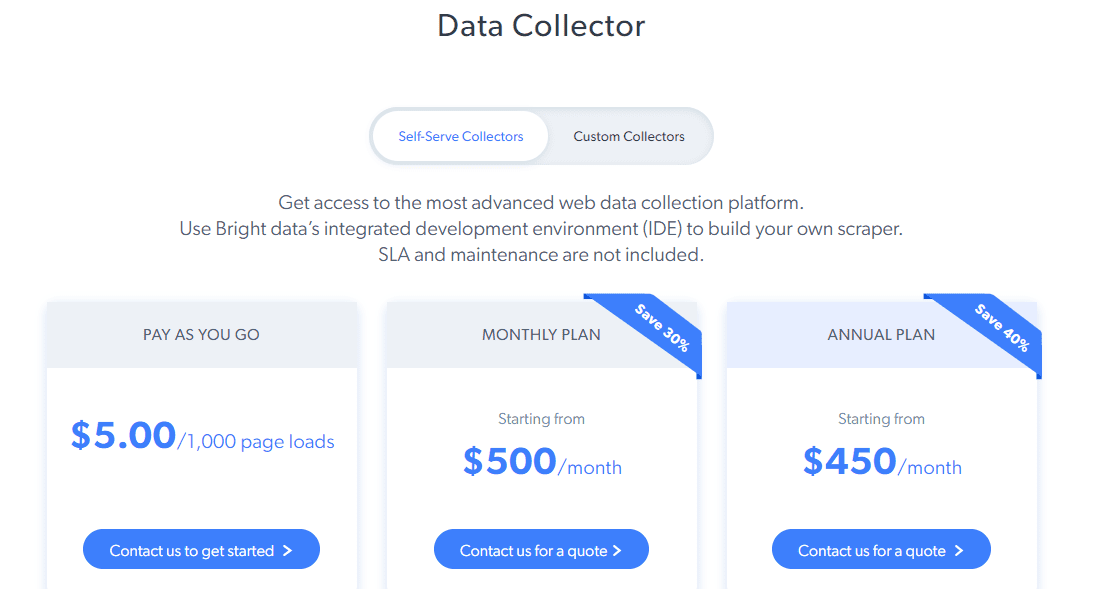

Bright Data Collector ofrece dos tipos de precios: recopiladores de autoservidor y recopiladores personalizados.

Recopilador de autoservicio: obtendrá acceso a funciones avanzadas como el IDE de Bright Data para crear su web scraper, alertas, monitoreo de la tasa de éxito, rendimiento más rápido, proxy de nivel industrial y más. Sus planes de precios son:

- Pago por uso: $5 por cada 1000 páginas cargadas

- Plan Mensual: Comienza desde $500 por mes

- Plan Anual: Comienza desde $450 por mes

Para coleccionistas personalizados, el precio comienza desde $1,000 por mes.

También hay una opción de prueba GRATUITA por un período limitado para decidir si se adapta a su caso de uso.

Alternativas a Bright Data Collector

No todos los productos se adaptan a todos. Ya sea por el precio, las funciones o las políticas, es posible que a algunas personas no les guste Bright Data Collector por algún motivo. Entonces, si eres ese alguien, echemos un vistazo a algunas de las mejores alternativas a Bright Data Collector.

Oxylabs

La popular plataforma, Oxylabs, ofrece una excelente API web scraper para que pueda recopilar datos sin esfuerzo.

Características clave

- Recopilación de datos de calidad de cualquier sitio web utilizando su rotador de proxy patentado

- Recopilación de datos de 195 países

- Restricciones geográficas fáciles de eludir

- Libre de mantenimiento

- Pagará solo por los datos que se entreguen con éxito

Puede probarlo gratis durante 7 días o elegir un plan a partir de $ 99 por mes.

Proxy inteligente

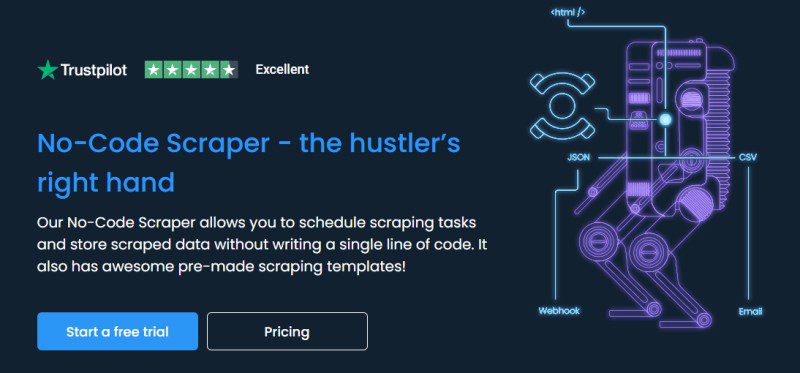

Si está buscando una plataforma sin código para web scraping que no sea Bright Data, pruebe Smartproxy. Lo ayudará a programar sus tareas de raspado web y almacenar datos de forma segura sin codificación.

Características clave

- Impresionantes plantillas de raspado listas para usar

- Configuración con un solo clic

- Exportación de datos en CSV o JSON

- Almacenamiento de datos en la nube

- Extensión gratuita de Chrome

Pruebe Smartproxy GRATIS durante 3 días o elija un plan a partir de $50 por mes.

Zyte

Zyte ofrece una API de extracción de datos web automatizada para permitir una recopilación de datos confiable, más rápida y segura sin ser expulsado de los sitios. Tiene una tecnología de inteligencia artificial patentada para la extracción automatizada para ayudarlo a brindar datos de calidad en la estructura.

Características clave

- Respuestas rápidas

- Datos de alta calidad de diez tipos

- API HTTP simplificada

- Más de 40 idiomas compatibles

- Se adapta a los cambios del sitio.

- Gestión antiprohibición integrada

- Escala ilimitada

Su plan de precios comienza en $ 60 por mes y la prueba GRATUITA está disponible durante 14 días.

Conclusión

El uso de una herramienta de recopilación de datos como Bright Data Collector puede hacer que su proceso de raspado web sea mucho más fácil con su interfaz intuitiva, rendimiento confiable y funciones útiles.

Entonces, si eres una organización, universidad o empresa de investigación, esta plataforma podría ser una buena opción. Sin embargo, si todavía está buscando alternativas de Bright Data, consulte las opciones anteriores y elija la que se adapte a sus necesidades.

También puede explorar algunas soluciones populares de web scraping basadas en la nube.